负载均衡的工作原理是通过分散网络负载,提高系统的整体性能和可靠性。它根据当前的网络流量、服务器性能等条件,智能地将请求分配给最合适的服务器处理。负载均衡采用多种技术,如DNS负载均衡、特定服务软件的负载均衡策略以及硬件负载均衡等。其核心在于智能分配和调度,确保系统资源得到高效利用,提高访问速度,增强系统的可扩展性和稳定性。

本文目录导读:

随着互联网技术的飞速发展,高并发、大流量的应用场景越来越普遍,如何保证系统的稳定性和性能成为了亟待解决的问题,负载均衡作为一种重要的技术手段,广泛应用于服务器集群、云计算、大数据等领域,本文将详细介绍负载均衡的工作原理及其在实际应用中的价值。

负载均衡概述

负载均衡是一种将网络请求分散到多个服务器上的技术,以提高系统的整体性能和稳定性,它通过优化网络资源的分配,实现请求在多个服务器之间的均衡分配,从而提高系统的吞吐量和响应速度,负载均衡可以分为硬件负载均衡和软件负载均衡两大类。

负载均衡的工作原理

负载均衡的工作原理主要包括以下几个步骤:

1、监测流量:负载均衡器会实时监测网络流量和服务器负载情况,这包括监测每台服务器的性能、负载状况以及网络带宽等信息。

2、分配策略:根据收集到的信息,负载均衡器会按照一定的策略进行分配,常见的分配策略包括轮询(Round Robin)、权重轮询(Weighted Round Robin)、最少连接数(Least Connections)等,这些策略根据服务器的性能和负载情况,将请求分配给最合适的服务器。

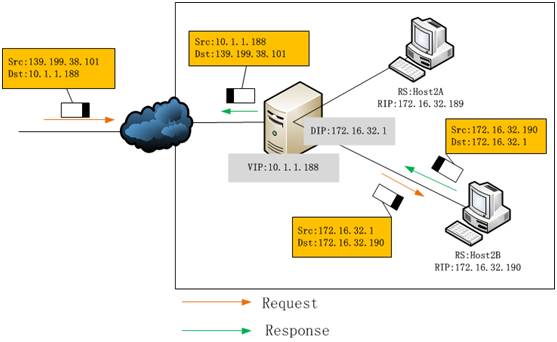

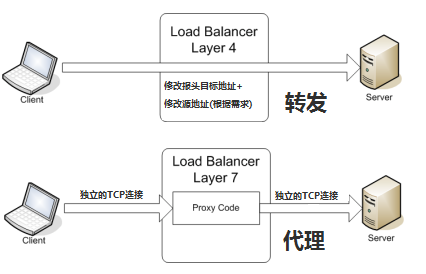

3、请求转发:一旦确定了目标服务器,负载均衡器会将请求转发给该服务器,这个过程需要保证请求的稳定性和安全性,确保请求能够准确无误地到达目标服务器。

4、实时监控与调整:负载均衡器会实时监控服务器集群的状态,并根据实际情况调整负载均衡策略,当某台服务器负载过高时,负载均衡器可以自动将部分请求转移到其他服务器,以保证系统的整体性能。

负载均衡的主要技术

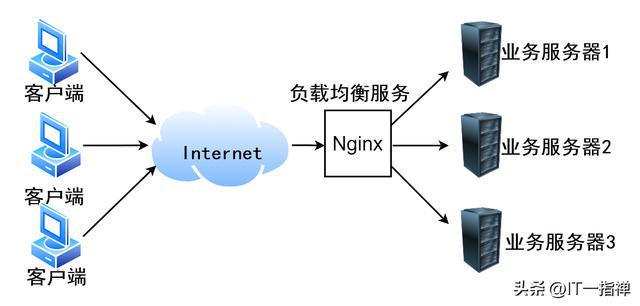

负载均衡技术主要包括DNS负载均衡、特定服务软件的负载均衡、硬件负载均衡器以及软件负载均衡等,软件负载均衡可以通过Nginx、HAProxy等工具实现,它们可以在不增加额外硬件成本的情况下提高系统的性能,云计算平台如AWS、阿里云等也提供了丰富的负载均衡服务,帮助用户轻松实现服务器集群的负载均衡。

负载均衡在实际应用中的价值

负载均衡在实际应用中具有广泛的应用价值,它可以提高系统的性能和稳定性,通过分散请求到多个服务器,避免单点故障,提高系统的整体吞吐量和响应速度,负载均衡可以提高系统的可扩展性,随着业务的发展,可以通过增加服务器节点来应对日益增长的请求量,而负载均衡技术可以确保新增节点能够自动参与到系统中,共同处理请求,负载均衡还可以提高系统的容错能力,当某台服务器出现故障时,负载均衡器可以自动将请求转移到其他正常运行的服务器,保证系统的持续运行。

负载均衡作为一种重要的网络技术手段,对于提高系统性能、稳定性和可扩展性具有重要意义,通过分散请求到多个服务器,避免单点故障,提高系统的整体吞吐量和响应速度,在实际应用中,我们可以根据需求选择合适的负载均衡技术和策略,以实现最优的系统性能,随着云计算、大数据等技术的不断发展,负载均衡将在更多领域得到广泛应用。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...