摘要:本文介绍了如何训练AI大模型以及最新的发展动态。训练AI大模型需要庞大的数据集、高性能计算资源和先进的算法技术。最新的发展动态包括模型规模的不断扩大、新型训练技术的出现以及跨领域应用的拓展。通过这些努力,AI大模型在语音识别、图像识别、自然语言处理等领域取得了显著进展,并有望在未来继续推动人工智能技术的快速发展。

本文目录导读:

随着信息技术的飞速发展,人工智能(AI)已经渗透到各个领域,其中大模型技术作为AI的核心,其训练和发展动态备受关注,本文将围绕AI大模型的最新发展动态进行解析,探讨如何有效训练AI大模型,以期为读者提供有价值的参考。

AI大模型概述

AI大模型是指规模庞大、参数数量众多的神经网络模型,具有强大的表征学习能力和任务适应性,近年来,随着数据量的增长和计算力的提升,AI大模型在图像识别、自然语言处理、语音识别等领域取得了显著成果。

AI大模型训练的关键技术

1、数据集:大规模高质量数据集是训练AI大模型的基础,为了获取更好的性能,需要不断扩充数据集,并对其进行清洗和标注。

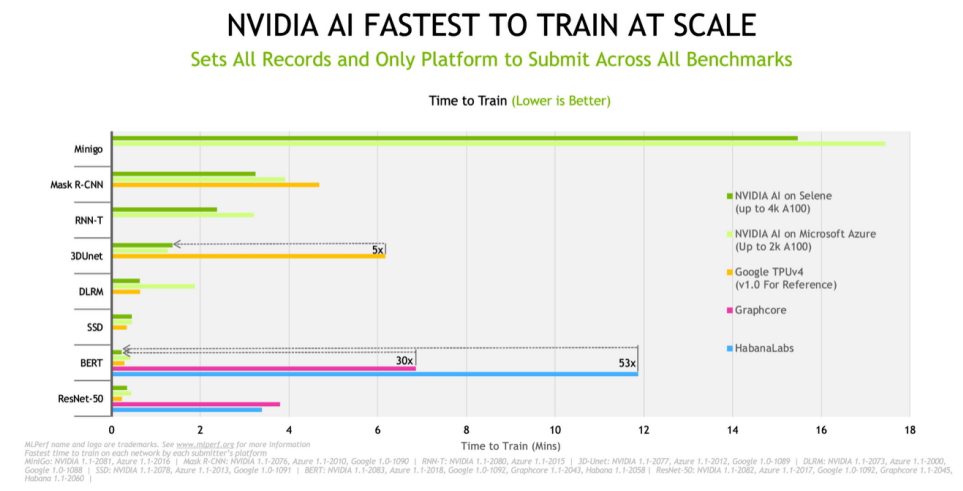

2、计算资源:AI大模型的训练需要大量的计算资源,包括高性能的计算机、云计算平台等,随着技术的发展,分布式训练和并行计算等技术为AI大模型的训练提供了有力支持。

3、算法优化:优化算法是提高AI大模型训练效率的关键,近年来,深度学习框架如TensorFlow、PyTorch等不断升级,为模型训练提供了更多优化手段。

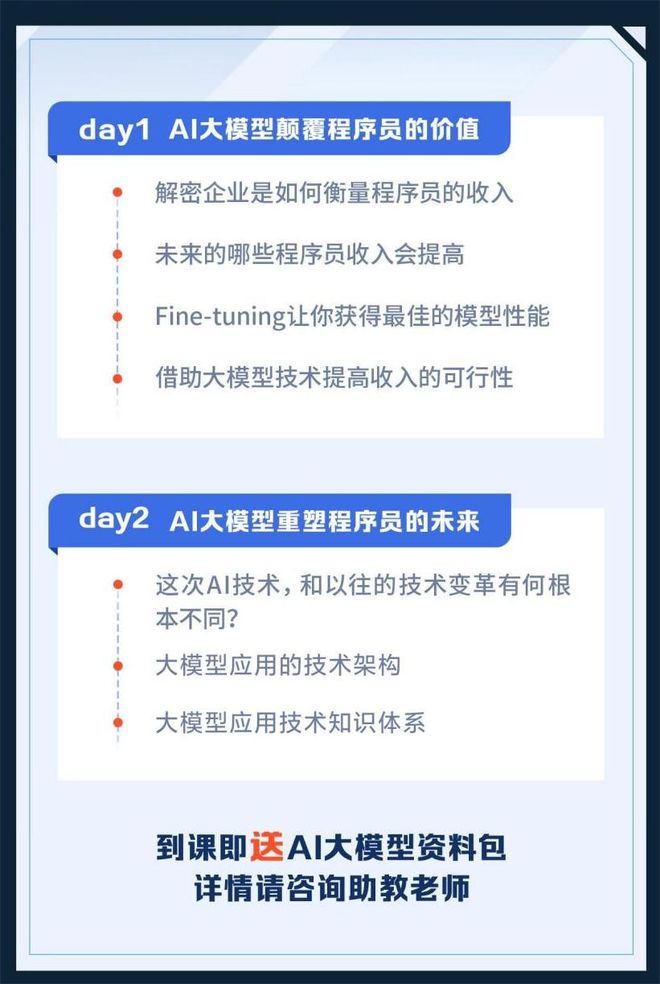

4、迁移学习:迁移学习在大模型训练中发挥着重要作用,通过迁移学习,可以利用预训练模型在特定任务上进行微调,从而提高模型的性能和泛化能力。

AI大模型的最新发展动态

1、模型规模的不断扩大:随着技术的不断发展,AI大模型的规模越来越大,参数数量不断刷新纪录,大规模的模型能够带来更好的性能,但同时也对计算资源和数据集提出了更高的要求。

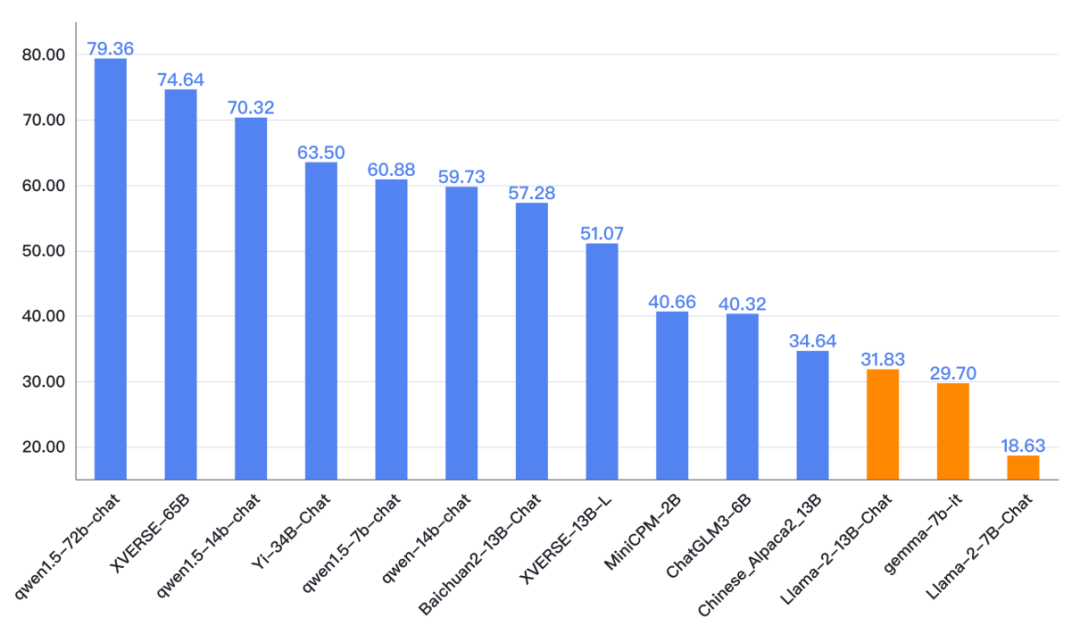

2、多样化的大模型结构:目前,AI大模型的结构越来越多样化,如Transformer、BERT、GPT等,这些新型的大模型结构在图像、文本、语音等领域取得了显著成果。

3、联邦学习:联邦学习作为一种新的分布式机器学习框架,在训练大模型方面展现出巨大潜力,通过联邦学习,可以在保护数据隐私的前提下进行模型训练,这对于处理敏感数据具有重要意义。

4、自适应训练:自适应训练技术能够根据数据的分布和模型的性能进行动态调整,提高大模型的训练效率和性能,目前,自适应训练技术已成为AI大模型研究的重要方向之一。

5、模型压缩与剪枝:为了在大规模模型中实现更高效的学习和推理,模型压缩与剪枝技术受到广泛关注,通过去除冗余的参数和结构,可以在保持模型性能的同时降低存储和计算需求。

6、多模态大模型:随着多模态数据的增长,多模态大模型逐渐成为研究热点,这类模型能够同时处理图像、文本、语音等多种数据,提高模型的跨领域学习能力。

面临的挑战与未来趋势

尽管AI大模型已经取得了显著成果,但仍面临诸多挑战,如数据隐私保护、计算资源需求、模型可解释性等,AI大模型的发展将朝着以下几个方向进行:

1、模型规模的进一步扩展:随着技术的不断进步,AI大模型的规模将继续扩大,性能将得到进一步提升。

2、跨领域的大模型融合:不同领域的大模型将进行融合,形成更具通用性的大模型,提高跨领域学习能力。

3、高效训练技术的研发:为了提高AI大模型的训练效率,将不断研发新的训练技术,如自适应训练、联邦学习等。

4、模型解释性的提升:为了提高模型的透明度和可信度,将加强模型解释性的研究,使AI大模型更易于人类理解。

5、大模型应用的普及:随着AI大模型的不断发展,其应用领域将越来越广泛,包括智能客服、自动驾驶、医疗诊断等。

AI大模型作为人工智能的核心技术之一,其最新发展动态备受关注,为了有效训练AI大模型,需要关注数据集、计算资源、算法优化、迁移学习等方面的关键技术,也需关注面临的挑战和未来趋势,以推动AI大模型的持续发展。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号